受到客觀因素影響,蘋果春季新品發(fā)布會不得不面臨改期或取消,就在人們還在期待新款廉價iPhone的到來之時,蘋果悄然在商店上架了新款的iPad Pro。

相比核心硬件方面從A12X升級到A12Z的小幅進步,最為核心的進步便是加入了“浴霸”攝像機矩陣,在1200萬像素廣角鏡頭(主攝像頭)的基礎(chǔ)上,加入了一枚1000萬像素的超廣角鏡頭。而更為重要的是,蘋果還加入了一個LiDAR(Light Detection And Ranging,光學(xué)雷達),實現(xiàn)了深度測量,借此實現(xiàn)更強大的AR(增強現(xiàn)實)功能。

為了突出這顆“LiDAR”的先進性,蘋果甚至在宣傳文案中還提到“就連NASA(美國國家航空航天局)也會在下次火星登陸任務(wù)中用到它”,雖然我們尚不清楚NASA何時“下次”登陸火星,但和航空航天聯(lián)系在一起,規(guī)格也如火箭一般被吹上了天。

速途網(wǎng)發(fā)現(xiàn),雖然蘋果在規(guī)格上把這顆光學(xué)雷達吹上了天,但在技術(shù)原理方面其實就是ToF技術(shù)范疇中的一個分支。而且小到手機,大到無人車,都能見到它的身影。

dToF技術(shù),移動傳感器的再升級

說到dToF,我們還要從他的本源“ToF”(Time of Flight,飛行時間)講起。顧名思義,就是通過計算光線發(fā)射器(通常為不可見光)與接收器接收到的反射光的時間差,測量雷達與物體之間距離的一項技術(shù)。

而這項技術(shù),早些年就已常見于各類半導(dǎo)體產(chǎn)品,例如在手機相機上,通過ToF技術(shù),可以實現(xiàn)測量物體間距,只不過那時更多被稱為“紅外對焦”、“激光對焦”;再后來更為高級的ToF也被用于物體3D掃描建模、3D人臉識別等。

在剛剛發(fā)布iPad Pro上,蘋果提到的“dToF”技術(shù),可以看作是上述提到的ToF的進階版本。

所謂“dToF”,其中“d”是“direct(直接)”的意思,即發(fā)射器發(fā)射脈沖光線,接受器接收反射光并計算其中時間差,即可實現(xiàn)距離測量。與普通手機紅外對焦所采用的iToF(i為indirect,間接),通過連續(xù)正弦波之間的相位差計算入射于發(fā)射時間差,再去計算物體距離的模式相比,dToF具有響應(yīng)更快、精度更高、抗干擾性強、感應(yīng)距離更長等優(yōu)勢,但相對體積更大、成本也更高,對于從硬件電路到軟件算法都有更為復(fù)雜的要求。

同時,無論哪種ToF,受限于移動設(shè)備尺寸與發(fā)射功率,感應(yīng)距離通常不超過5米,且距離越遠功耗越大、精度越低。

激光雷達的廣泛應(yīng)用

至于LiDAR如何在NASA登陸火星中大顯神威,可能離大家“太遠”無法感知,然而在自動駕駛領(lǐng)域,LiDAR幾乎成為了一項非常主流的技術(shù),同時隨著車輛網(wǎng)以及道路“新基建”的建設(shè),可能很快就將照進現(xiàn)實。

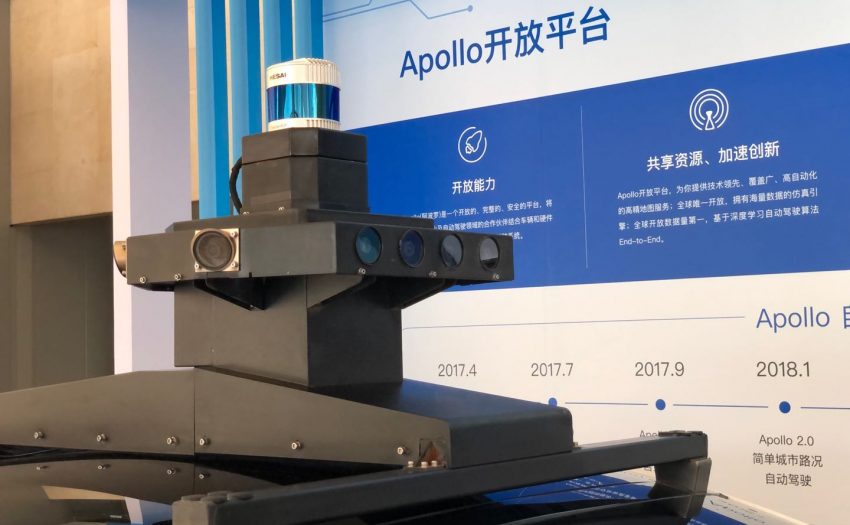

圖為百度Apollo平臺自動駕駛車輛頂部的雷達矩陣

相比移動設(shè)備上所采用的光學(xué)雷達,車載雷達要面對更為廣闊的道路空間、以及更為復(fù)雜的道路狀況,所以在體積以及發(fā)射功率上都會更大。同時由于自動駕駛的核心在于在高速行進的過程中保障安全駕駛,所以更需要厘米級別的精確距離,那對傳輸時間測量分辨率必須做到1納秒。

而這樣的激光雷達,隨著自動駕駛研究的演進,我們很快就能在地球上越來越多地見到。不過,在功能上更接近NASA火星登陸器的的車載激光雷達短期無法擺脫大體積、高成本的制約(單個成本在數(shù)萬元以上)。而iPad上的LiDAR只是同類產(chǎn)品中的縮微版本。

結(jié)構(gòu)光+ToF,蘋果面對AR的雙重準備

值得一提是,隨著LiDAR元件的加入,新款的iPad Pro成為了蘋果首個集正面“3D結(jié)構(gòu)光”與背面“ToF”兩種技術(shù)方案為一體的機型。

3D結(jié)構(gòu)光作為蘋果在2017年iPhone X上首次亮相的技術(shù),通過投影器向物體平面主動投影已知圖案,同時通過攝影機采集匹配特征點,來實現(xiàn)對于物體深度信息的測量。

其中3D結(jié)構(gòu)光測量距離最短、精度最高,因此被安放在正面用于3D人臉解鎖、支付認證、以及人像美顏等功能;而ToF雖精度稍遜于結(jié)構(gòu)光,但有效距離更長(5米內(nèi)),可以輔助設(shè)備實現(xiàn)一定空間內(nèi)深度信息的捕捉,適合在室內(nèi)進行更為精準的AR應(yīng)用;而再大范圍的取景,由于實際精度要求更低,通過設(shè)備現(xiàn)有的攝像頭的景深測量即可實現(xiàn)。

2017年,蘋果在WWDC上,正式面向開發(fā)者推出了ARkit,將相機、動作傳感器以及圖形處理器等硬件特性與深度感應(yīng)、人造光渲染等精密算法結(jié)合,可以讓開發(fā)者們將更多 AR 應(yīng)用代入到 iOS 設(shè)備。雖然蘋果在AR研究方面起步并不算早,但通過平臺對于開發(fā)者的強大號召力,通過為開發(fā)者提供成熟的開發(fā)套件,“催熟”AR應(yīng)用生態(tài)。

可以說,光學(xué)雷達的加入,短期內(nèi)為蘋果在建設(shè)AR生態(tài)上提供了更為豐富的傳感器種類,也讓iPad這個“平板電腦”的形態(tài)在一些功能上做到了傳統(tǒng)PC做不到的事,在手機與PC之間爭取了更多“夾縫中生存”的機會。

而從長期來看,傳感器相關(guān)技術(shù)的積累,也為蘋果日后推出更新形態(tài)的硬件產(chǎn)品夯實基礎(chǔ),例如AR眼鏡、蘋果汽車等,雖然在蘋果嚴格保密的企業(yè)文化下,我們尚不能看到這些設(shè)備的雛形,但從產(chǎn)品搭載的新技術(shù)以及相繼曝光的專利來看,這些已經(jīng)不再是“空中樓閣”。