比LLaMA更小,比LLaMA(65B)更強!

5月27日,阿拉伯聯合酋長國技術創新研究院(TII)發布了史上最強大的基礎模型:FalconLM。

值得注意的是,該模型目前在Huggingface排行榜上排名第一

除了不斷增大的模型外,TII還發布了一個用于訓練模型的數據集。該數據集包含1.5萬億個參數,

Falcon LLM是一個基礎性的大型語言模型(LLM),在一萬億個令牌上訓練了400億個參數。TII現已發布獵鷹LLM——40B型號。

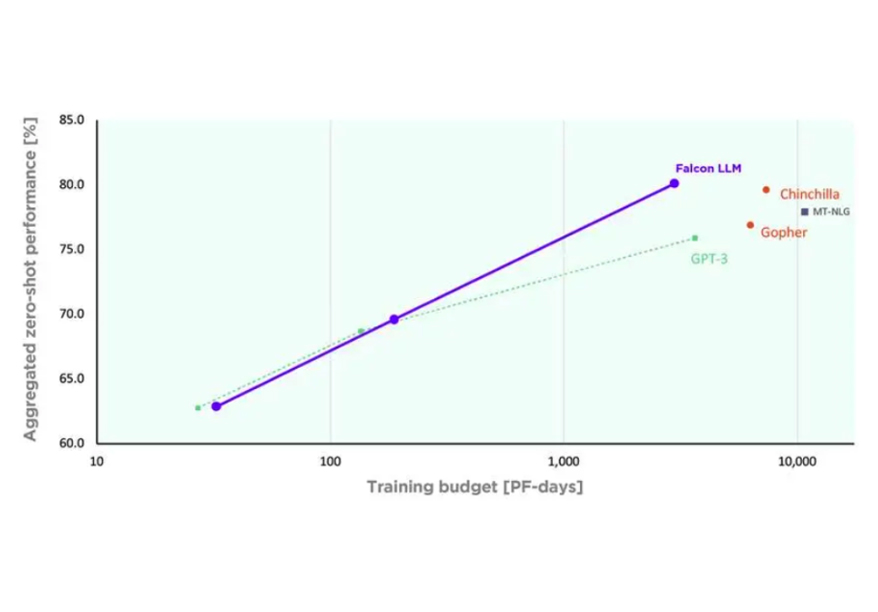

該模型僅使用GPT-3訓練計算的75%、Chinchilla的40%和PaLM-62B的80%。

可以肯定的是FalconLM模型目前超越所有其他開源模型(如Redpajama、MPT、LLaMA等)。

該模型使用RoPE嵌入、閃電注意力和多查詢注意力進行訓練,因此其推理效果得到了優化。它有7B和40B兩個版本可用。此外,該模型還提供了針對指令執行進行優化的Instruct版本,但不適用于微調。

另外,他們還推出了一個前瞻性的許可證。它允許商業使用,但對于任何使用該模型的用例所產生的收入超過100萬美元的部分,他們要求收取10%的版稅。