今年以來,大模型的火熱發展不僅讓人工智能重回行業舞臺中心,對于產業新一輪價值增長也提供了新勢能。然而,隨著大模型技術研發的深入,參數規模增長,也使得相關的計算資源需求的急劇增加,為大模型發展的新一輪突破帶來了挑戰。

因此,高算力芯片的需求變得更為迫切,這種需求不僅僅體現在模型訓練和推理上,同時也延伸到了API調用等方方面面。擁有足夠的算力資源,已經成為評估一個人工智能企業實力的硬指標之一。

近期,OpenAI的負責人山姆·奧特曼(Sam Altman)公開表示,盡管目前還在評估中,但OpenAI并不排除自研 AI芯片的可能性。除了可能的自研計劃,OpenAI也為此投資了Cerebras、Rain Neuromorphics、Atomic Semi等頗具潛力的芯片初創公司,旨在更快、更廉價地生產芯片。

除了OpenAI外,人工智能企業的巨頭,例如微軟、谷歌、Meta等企業也在積極探索AI芯片的研發。一時之間,AI芯片相關的課題,又成為大模型廣泛應用的“仰望星空”前,首先需要“腳踏實地”解決的問題。AI芯片核心技術自研箭在弦上

眾所周知,隨著“百模大戰”的局面已然形成,大模型設計和實現上取得了顯著進展,參數規模增長相關的計算資源需求的急劇增加,訓練和推理所需的計算資源也呈指數級增長。然而,算力作為人工智能發展的三要素之一,現實世界中有限的計算資源,訓練和推理過程變得更加耗時和昂貴。

從技術架構來看,AI芯片主要分為圖形處理器(GPU)、現場可編程門陣列(FPGA)、專用集成電路(ASIC)、中央處理器(CPU)四大類。其中,GPU是較為成熟的通用型人工智能芯片,作為重要的計算資源在人工智能領域中發揮著關鍵作用。特別是GPGPU技術的應用,使得GPU在云端進行大模型訓練算法時能夠顯著縮短訓練時長,減少能源消耗,降低人工智能的應用成本。FPGA和ASIC則是針對人工智能需求特征的半定制和全定制芯片,原則上定制化程度越高,所能兼容的算法種類就越少,但進行AI加速時擁有更好的性能與更低的功耗。

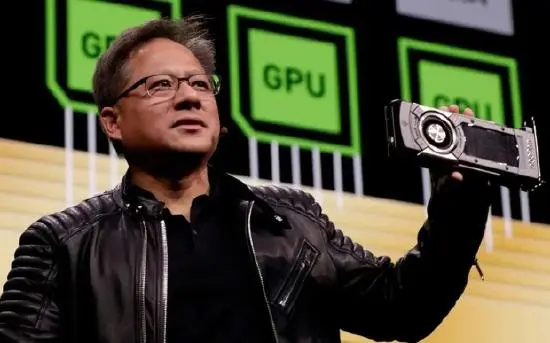

大模型之家在《人工智能大模型產業創新價值研究報告》中指出,在全球算力市場中,英偉達作為高算力芯片的龍頭企業,占據著領先地位。其A100、H100顯卡適用于支持各種機器學習模型,具備強大的數據處理能力,使其成為目前主流的AI芯片。目前,全球GPU市場中英偉達占據近90%份額。

在生成式人工智能熱潮所引發的強勁需求下,英偉達第二季度營收達135.1億美元,同比增長101%,創下歷史新高,凈利潤達61.88億美元,同比暴漲843%。此外,英偉達首席執行官黃仁勛指出,全球已裝設價值約1兆美元的數據中心,包括云、企業等領域,這一兆美元的數據中心正逐漸轉向加速運算和生成式AI,也讓數據中心業務收入103億美元,同比增長170%,成為新的增長引擎。

雖然亞馬遜、Meta、寒武紀、地平線等國內外科技巨頭都推出過AI芯片,但從使用場景上更多是用于AI運算加速,即推理方面,這種自研芯片的優勢在于可以大幅降低算力成本。

而在AI訓練方面,英偉達憑借CUDA生態優勢,在AI及高性能計算等核心技術領域,仍然具備一定的領先優勢。

而AMD、谷歌等企業雖然分別采用兼容CUDA和自研TPU的方式切入AI芯片賽道,試圖從AI訓練需求中分得一杯羹,但兩者本身性能相比于英偉達同時期GPU而言性能與功耗方面還有一定差距,因此在市場表現上只能算差強人意。

可以說,在英偉達因為AI賺得盆滿缽滿的現狀之下,有的企業想要搶奪英偉達在AI算力上的蛋糕,也有的企業想要實現芯片自主,在實現軟硬協同的同時,節約芯片成本。

在大模型技術的全球化競爭面前,芯片也將成為核心競爭力之一。10月18日,美國計劃進一步收緊對華AI芯片出口管制,并將管制擴大至更多國家。據稱,新規將取消芯片的通信速度限制,并將重點放在計算性能上,這將導致原本可以在中國市場銷售的英偉達A800和H800芯片停售(halting sales)。這兩款芯片是英偉達去年為符合美出口管制要求定制的產品。

而國內在GPU領域,雖然在圖形處理性能上已經快步縮小與頭部企業差距,但在GPGPU領域,在算力、端口性能、生態等方面仍然與巨頭有著一定的差距,雖然短期內,國內AI芯片市場仍然需要奮力追趕,但從長期看來,這種競爭將推動我國積累和發展芯片核心技術,促使我們在全球芯片領域取得更大的成就。端側人工智能推動芯片AI能力升級

大模型的“芯戰”,不僅體現在大模型本身的開發上。隨著分布式計算技術需求的不斷普及,以及用戶對于個人數據隱私需求的不斷升級。如今,大模型在端側的部署,也推動著智能設備在芯片方面擁有更高的AI能力。

在2023驍龍峰會期間,高通技術公司發布了驍龍 XElite、第三代驍龍8移動平臺等芯片新品,驍龍X Elite是為AI專門打造的PC計算平臺,支持在終端側運行超過130億參數的生成式AI模型。而第三代驍龍8移動平臺NPU相比前代有98%的性能提升,模塊支持獨立供電,達到40%的能效提升。得益于端側的算力提升,依靠本地大模型,就能進行生成式AI的交互。

除此之外,聯發科也在近期與vivo共同宣布,在行業內首次實現了手機上的10億和70億AI大語言模型,以及10億AI視覺大模型,共同為消費者帶來行業領先的端側生成式AI應用創新體驗,正是基于即將發布的天璣9300旗艦芯片和vivo X100系列。

在蘋果上個月發布的iPhone 15 Pro系列所搭載的A17 Pro芯片中,搭載了16核Neural Engine神經網絡引擎,運行速度比上代快2倍,每秒可處理多達35萬億次運算。這意味著A17 Pro能夠更有效地執行復雜的AI任務,如深度學習、語音識別和圖像處理等,從而提供更好的用戶體驗,為蘋果的產品帶來了更多的創新可能,如光線追蹤、ProRes視頻錄制等功能。

同時,有消息稱蘋果公司也在擴大其AI工程師的招聘力度,并計劃整合其各種服務和平臺中的人工智能元素。蘋果還同時在內部構建文本生成技術等任務,如長文本生成、摘要、問答等。

不只是手機產品,在PC產品線上,AI能力也成為了打造差異化賣點的重要方式。在上個月微軟發布會上,不僅再次重提Copilot的無縫AI體驗,在Surface產品線更新中,全新的Laptop Studio 2還成為配備獨立英特爾NPU的Windows計算機。

可見,大模型在端側的應用,未來或將成為手機、PC等智能設備的標配。一方面,本地部署的大模型,能夠有效提升大模型處理的速度;另一方面,模型無需聯網即可完成用戶數據的訓練,大大提升了數據安全的防護能力,讓用戶在使用時減少隱私信息泄漏的隱患。

在大模型之家看來,隨著大模型在產業中全面落地已經成為不可阻擋的趨勢,搭載大模型的智能設備將滲透你我工作與生活的方方面面。而作為算力的硬件載體,芯片必然將成為企業角力的焦點。

無論是在移動設備上,還是在云端數據中心,高性能、低能耗的芯片將成為各類智能應用的核心。面對日益龐大的大模型計算需求,各大科技企業紛紛亮出了自家芯片的底牌,希望在這場硬件競賽中取得先機,而那些能夠在芯片技術上取得突破的企業,將在人工智能領域占據重要地位,引領產業未來的發展方向。