剛剛在斯坦福商學院SIEPR經濟峰會上提出“在未來的10年里,英偉達將會把深度學習的計算能力再提高100萬倍。”豪言壯語的黃仁勛,憑借一顆B200又一次“沸騰”了整個AI行業。

在當地時間3月18日的演講中,英偉達的黃仁勛發表了題為《見證AI的變革時刻》的主題演講,介紹了英偉達在最新研發進展方面的成果。他圍繞五大板塊,分別是新的產業發展、Blackwell平臺、創新軟件NIMs、AI平臺NEMO和AI工坊服務,以及仿真平臺Omniverse和適用于自主移動機器人的Isaac Robotics平臺展開了介紹。

英偉達“史上最成功的產品”

其中,最為炸場的,莫過于黃仁勛首次揭示了英偉達的最新一代AI芯片Blackwell GPU,即B200,這一GPU平臺也是黃仁勛口中“英偉達史上最成功的產品”。

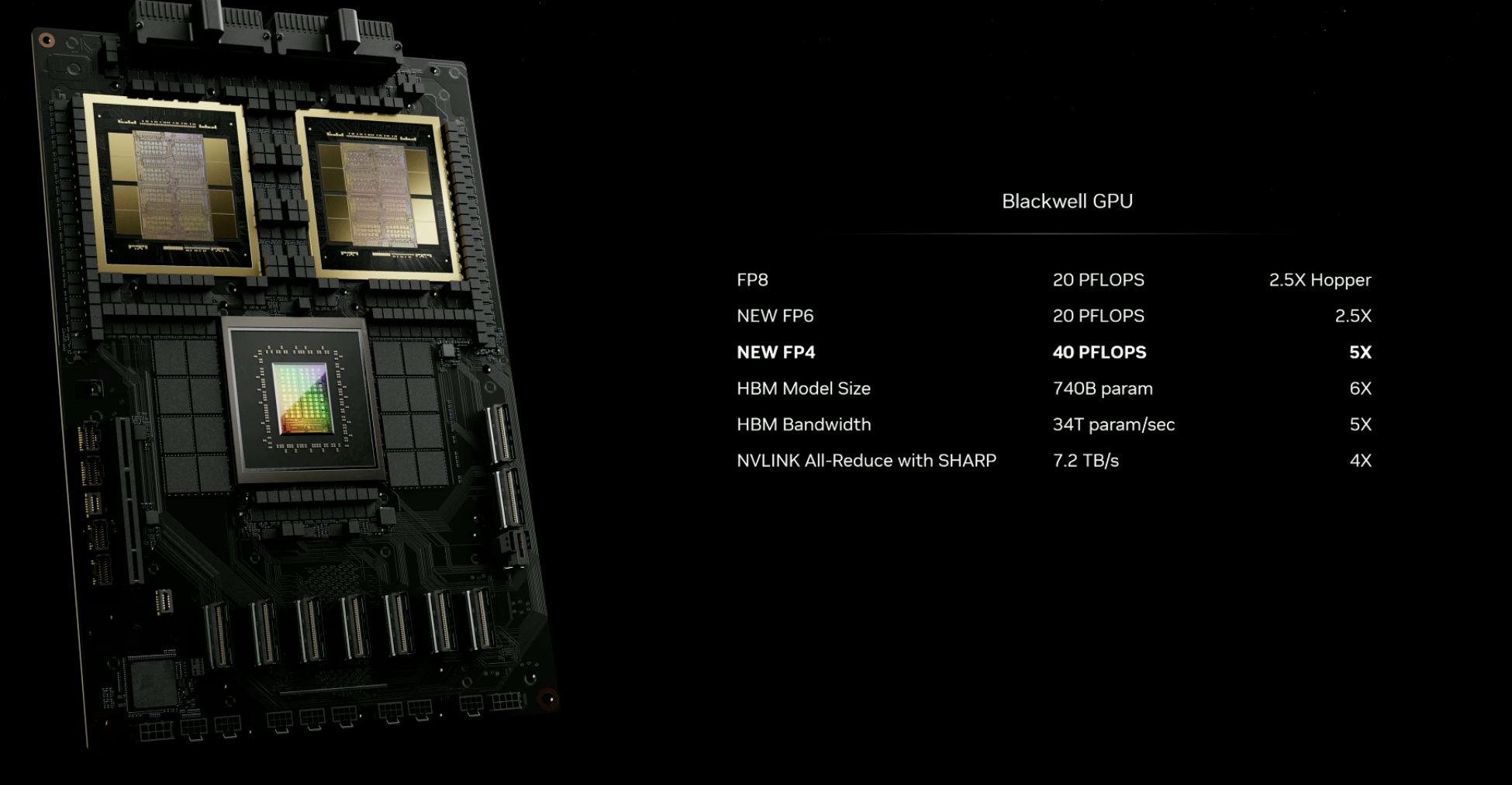

據介紹,Blackwell GPU以數學家David Harold Blackwell的名字命名,該芯片采用臺積電的4納米工藝,擁有2080億個晶體管,同樣沿用了英偉達此前推出的Hopper架構,可以支持多達10萬億個參數的AI模型。據介紹,B200能夠提供高達20 PFlops的FP4八精度浮點運算能力,較之前的產品性能有了質的飛躍。此外,黃仁勛還展示了基于B200的GB200加速卡,帶來了巨大的性能提升和效率提高。此外,Blackwell 架構還采用了第五代NVLink高速互聯、第二代Transformer引擎等多方位全面升級。

不僅單塊GPU性能大幅提升,兩個B200 GPU與Grace CPU結合就成為GB200超級芯片,通過900GB/s的超低功耗NVLink芯片間互連技術連接在一起,成為一個Blackwell計算節點。

在NVLink Switch支持下,英偉達暴力地將72塊B200連接在一起,最終成為“新一代計算單元”GB200 NVL72。一個像這樣的“計算單元”機柜,FP8精度的訓練算力就高達720PFlops,直逼H100時代一個DGX SuperPod超級計算機集群(1000 PFlops)。與相同數量的72個H100相比,GB200 NVL72對于大模型推理性能提升高達30倍,成本和能耗降低高達25倍。

英偉達還透露,這一全新的芯片將在2024年晚些時間上市。目前,亞馬遜、戴爾、谷歌、Meta、微軟、OpenAI、特斯拉都已經計劃使用Blackwell GPU。

除了硬件創新,英偉達還在軟件領域取得了新的進展。NIM微服務是其中的一項亮點,它可適用于優化英偉達生態系統中的20多個AI模型,為企業提供定制化的AI應用開發和部署服務。此外,黃仁勛還介紹了英偉達的仿真平臺Omniverse和Isaac Robotics平臺,展示了英偉達在機器人領域的前瞻性布局和創新成果。

AI行業的“新摩爾定律”

在大模型引領的人工智能的熱潮之下,憑借著GPU的算力以及帶寬領域的優勢,以及自身的CUDA生態優勢,不僅讓英偉達成為AI領域最賺錢的企業之一,同時也讓黃仁勛在AI時代有了更大的“野心”。在英偉達2023年財報中,截至9月數據中心的收入為150億美元,到了2023年底,其收入同比增長了279%。

剛剛在斯坦福商學院SIEPR經濟峰會上提出“在未來的10年里,英偉達將會把深度學習的計算能力再提高100萬倍。”

如果將這一目標解構,便可以粗略得出英偉達每年要將算力提升為前一年的4倍。這意味著,如果英偉達的目標真正實現,這家公司將成為引導AI行業“新摩爾定律”發展的奠基者。

眾所周知,“摩爾定律”是英特爾創始人之一戈登·摩爾的經驗之談,其核心內容為:集成電路上可以容納的晶體管數目在大約每經過18個月到24個月便會增加一倍。而對于英偉達而言,“每12個月將AI算力提升4倍”的目標,相比摩爾定律,無疑顯得更加樂觀與激進。

要知道,此前8年時間的時間里,AI算力的增長也僅僅在以“千”為量級。

根據英偉達現場發布的公開資料,新一代AI芯片B200在處理支持人工智能的模型方面表現出了顯著的性能提升。與之前的H100相比,B200在開發技術的過程(預訓練階段)以及技術運行過程(推理)中的速度都提高了數倍。

具體來說,以前訓練一個擁有1.8萬億參數的模型需要8000個H100GPU和15兆瓦的功率。而如今,使用新的B200芯片,同樣的模型只需要2000個GPU就可以完成訓練,同時功耗僅為4兆瓦,相當于原先功耗的約四分之一。這意味著在相同的任務下,使用B200芯片進行訓練不僅速度更快,而且能夠顯著降低能源消耗,提高效率。

可以說,從性能與能效表現的角度來看,英偉達新一代AI芯片B200確實的有了長足的進步。不過,大模型之家也注意到,盡管第五代NVLink Switch高速互聯技術為每個GPU 提供了1.8TB/s雙向吞吐量,確保多達576個GPU之間的無縫高速通信,同時大幅節約了能耗。

但面對4nm工藝制程即將達到極限,英偉達選擇提升算力的方式非常的粗暴,通過堆砌運算單元規模,實現性能的大幅提升。這意味著,在大模型訓練算力6個月翻一番的預期之下,想要實現算力的持續供給,需要不斷更新迭代硬件設備,甚至不斷擴建更大的算力集群。

這意味著,英偉達將核心發力點放在了“更大”與“更強”之上,通過不斷探索AI算力的極限,在開辟加速計算領域的“新摩爾定律”的同時,收割頭部AI企業對于算力增長的需求。

寫在最后

在Blackwell芯片的背后,我們可以看到“新摩爾定律”并非遙不可及,但也要注意到盡管NVIDIA將可擴展的GPU架構與摩爾定律相結合,但硬件性能的提升現在更多依賴于芯片之間的互聯。此外,硬件性能的提升并非像宣傳中所說的那樣夸張,而是通過不斷提升數據精度實現的,從最初的高性能計算到現在的FP64、FP32、FP16、FP8以及FP4,這也預示著隨著半導體行業逐漸逼近物理極限,大模型對于算力的提升也要尋找新的突破方式。

同時,GB200 NVL72的液冷機架以及“超級盒子”DGX SuperPOD的發布,也為大型模型公司提供了更便捷的“批發”選擇,極高的性能背后,其不菲的價格也將進一步提振英偉達未來的營收預期。

但不可否認的是,英偉達此次發布的一系列設備,使得IT部門能夠為各用戶和工作負載提供出色的性能,成為AI數據中心基礎設施的典范。在更強大算力的支撐之下,人工智能領域的新一輪突破也將指日可待。