3 月 18 日,昆侖萬維正式開源首款工業(yè)界多模態(tài)思維鏈推理模型 Skywork-R1V,開啟多模態(tài)思考新時代。繼 Skywork-R1V 首次成功實現(xiàn)“強文本推理能力向視覺模態(tài)的遷移”之后,昆侖萬維再度發(fā)力,今天正式開源多模態(tài)推理模型的全新升級版本 —— Skywork-R1V 2.0(以下簡稱 R1V 2.0) 。

01

R1V 2.0 性能全面提升并開源,視覺與文本推理能力雙管齊下

Skywork-R1V 2.0 是當前最均衡兼顧視覺與文本推理能力的開源多模態(tài)模型,該多模態(tài)模型在高考理科難題的深度推理與通用任務場景中均表現(xiàn)優(yōu)異,真正實現(xiàn)多模態(tài)大模型的“深度 + 廣度”統(tǒng)一。升級后的 R1V 2.0 模型頗具亮點:

-中文場景領跑:理科學科題目(數(shù)學/物理/化學)推理效果拔群,打造免費AI解題助手;

-開源巔峰:38B 權重 + 技術報告全面開源,推動多模態(tài)生態(tài)建設;

-技術創(chuàng)新標桿:多模態(tài)獎勵模型(SkyworkVL Reward) 與 混合偏好優(yōu)化機制(MPO),全面提升模型泛化能力;選擇性樣本緩沖區(qū)機制(SSB),突破強化學習“優(yōu)勢消失”瓶頸。

在多個權威基準測試中,R1V 2.0 相較于 R1V 1.0 在文本與視覺推理任務中均實現(xiàn)顯著躍升。無論是專業(yè)領域任務,如數(shù)學推理、編程競賽、科學分析,還是通用任務,如創(chuàng)意寫作與開放式問答,R1V 2.0 都呈現(xiàn)出極具競爭力的表現(xiàn):

-在 MMMU 上取得 73.6 分,刷新開源 SOTA 紀錄;

-在 Olympiad Bench 上達到 62.6 分,顯著領先其他開源模型;

-在 MathVision、MMMU-PRO 與 MathVista 等多項視覺推理榜單中均表現(xiàn)優(yōu)異,多項能力已可媲美閉源商業(yè)模型,堪稱當前開源多模態(tài)推理模型中的佼佼者。

在與開源多模態(tài)模型的對比中,R1V 2.0 的視覺推理能力(在眾多開源模型里)脫穎而出。

如下圖所示,R1V2.0 也展現(xiàn)出媲美商業(yè)閉源多模態(tài)模型的實力。

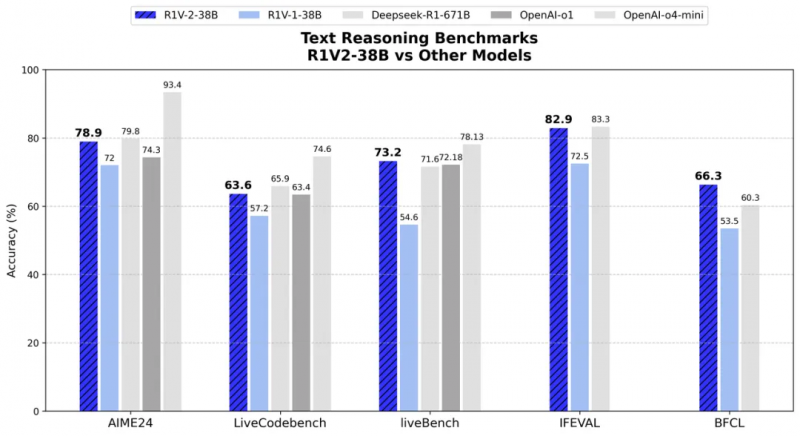

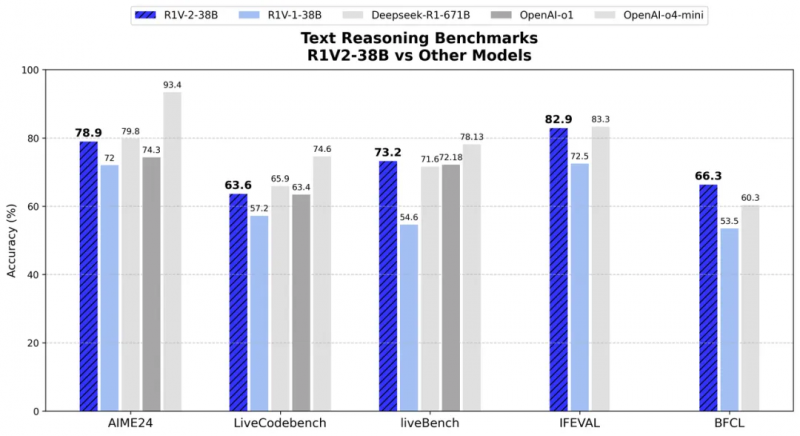

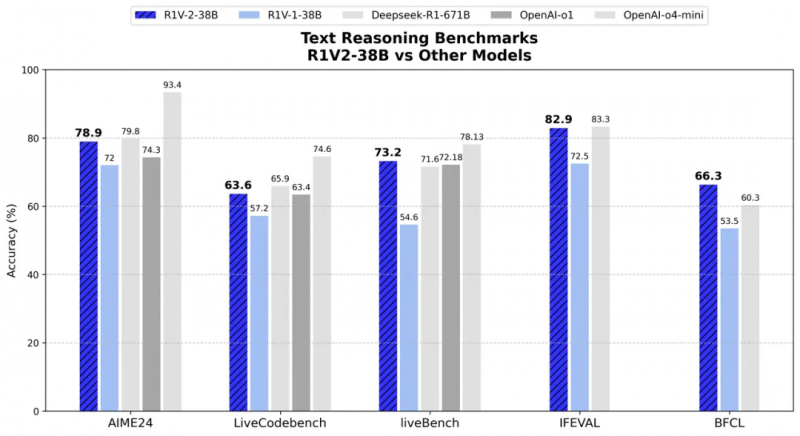

而在文本推理方面,在 AIME2024 和 LiveCodeBench 等挑戰(zhàn)中,R1V 2.0 分別取得了78.9 分和 63.6 分,展現(xiàn)出了人類專家級數(shù)學與代碼理解能力。在與專用文本推理模型對比中,R1V2.0 同樣展現(xiàn)出卓越的文本推理能力。

02

技術亮點一:推出多模態(tài)獎勵模型 Skywork-VL Reward,全面開源

自 R1V 1.0 開源以來,昆侖萬維團隊收獲了來自全球開發(fā)者與研究者的廣泛反饋。在模型推理能力顯著提升的同時,團隊也發(fā)現(xiàn),過度集中于推理任務的訓練,會限制模型在其他常規(guī)任務場景下的表現(xiàn),影響整體的泛化能力與通用表現(xiàn)。

為實現(xiàn)多模態(tài)大模型在“深度推理”與“通用能力”之間的最佳平衡,R1V 2.0 引入了全新的「多模態(tài)獎勵模型 Skywork-VL Reward」及「規(guī)則驅動的混合強化訓練機制」。在顯著增強推理能力的同時,進一步穩(wěn)固了模型在多任務、多模態(tài)場景中的穩(wěn)定表現(xiàn)與泛化能力。

Skywork-VL Reward,開啟多模態(tài)強化獎勵模型新篇章:

當前,行業(yè)中多模態(tài)獎勵模型的缺乏,已成為強化學習在 VLM(Vision-Language Models)領域進一步發(fā)展的關鍵瓶頸。

現(xiàn)有獎勵模型難以準確評價跨模態(tài)推理所需的復雜理解與生成過程。為此,昆侖萬維推出了 SkyworkVL Reward模型,既可為通用視覺語言模型(VLM)提供高質量獎勵信號,又能精準評估多模態(tài)推理模型長序列輸出的整體質量,同時也可以作為并行線上推理最優(yōu)答案選擇的利器。

這種能力使得 Skywork-VL Reward 模型在多模態(tài)強化學習任務中具有廣泛的適用性,促進了多模態(tài)模型的協(xié)同發(fā)展:

-跨模態(tài)引領者:率先提出多模態(tài)推理與通用獎勵模型,推動多模態(tài)強化學習;

-榜單標桿:在視覺獎勵模型評測中名列第一,7B 權重與技術報告全面開源;

-信號全覆蓋:支持從短文本到長序列推理的多元化獎勵判別。

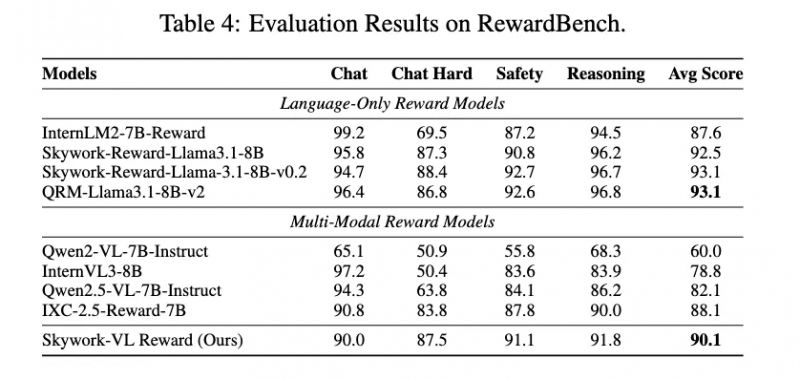

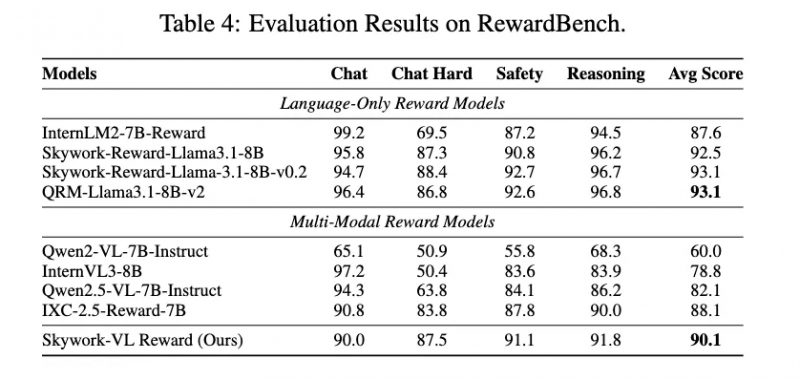

Skywork-VL Reward 在多個權威評測榜單中表現(xiàn)優(yōu)異:在視覺獎勵模型評測榜單 VL-RewardBench 中取得了 73.1 的SOTA成績,同時在純文本獎勵模型評測榜單 RewardBench 中也斬獲了高達 90.1 的優(yōu)異分數(shù),全面展示了其在多模態(tài)和文本任務中的強大泛化能力。

為回饋社區(qū)和行業(yè),團隊也將 Skywork-VL Reward 完整開源。

03

技術亮點二:引入多重優(yōu)化策略提升核心效果

長期以來,大模型訓練面臨“深度推理提升”與“通用能力保持”的難以兼得難題。為解決這一“推理–通用”的能力蹺蹺板問題,以及解決通用問題沒有直接可驗證的答案的挑戰(zhàn),R1V 2.0 引入了 MPO(Mixed Preference Optimization,混合偏好優(yōu)化) 機制,并在偏好訓練中充分發(fā)揮 Skywork-VL Reward 獎勵模型的指導作用。

和 R1V 1.0 思路類似,我們使用提前訓練好的 MLP 適配器,直接將視覺編碼器 internVIT-6B 與原始的強推理語言模型 QwQ-32B 連接,形成 R1V 2.0-38B 的初始權重。這樣一來,R1V 2.0 在啟動即具備一定的多模態(tài)推理能力。

在通用任務訓練階段,R1V 2.0 借助 Skywork-VL Reward 提供的偏好信號,引導模型進行偏好一致性優(yōu)化,從而確保模型在多任務、多領域下具備良好的通用適應能力。實驗證明,Skywork-VL Reward 有效實現(xiàn)了推理能力與通用能力的協(xié)同提升,成功實現(xiàn)“魚與熊掌兼得”。

在訓練深度推理能力時,R1V 2.0 在訓練中采用了 基于規(guī)則的群體相對策略優(yōu)化GRPO(Group Relative Policy Optimization) 方法。該策略通過同組候選響應之間的相對獎勵比較,引導模型學會更精準的選擇和推理路徑。

R1V 2.0 所采用的多模態(tài)強化訓練方案,標志著大模型訓練范式的又一次重要革新,也再次驗證了強化學習在人工智能領域無法撼動的地位。通過引入通用性更強的獎勵模型 Skywork-VL Reward,以及高效穩(wěn)定的樣本利用機制 SSB,我們不僅進一步提升了R1V系列模型在復雜任務中的推理能力,同時也將開源模型跨模態(tài)推理泛化能力提升到了全新高度。

R1V 2.0 的誕生,不僅推動了開源多模態(tài)大模型在能力邊界上的突破,更為多模態(tài)智能體的搭建提供了新的基座模型。

04

面向AGI的持續(xù)開源

最近一年以來,昆侖萬維已陸續(xù)開源多款核心模型:

開源系列:

1. Skywork-R1V 系列:38B 視覺思維鏈推理模型,開啟多模態(tài)思考時代;

2. Skywork-OR1(Open Reasoner 1)系列:中文邏輯推理大模型,7B和32B最強數(shù)學代碼推理模型;

3. SkyReels系列:面向AI短劇創(chuàng)作的視頻生成模型;

4. Skywork-Reward:性能卓越的全新獎勵模型。

這些項目在 Hugging Face 上廣受歡迎,引發(fā)了開發(fā)者社區(qū)的廣泛關注與深入討論。

我們堅信,開源驅動創(chuàng)新,AGI 終將到來。

正如 DeepSeek 等優(yōu)秀團隊所展現(xiàn)的那樣,開源模型正逐步彌合與閉源系統(tǒng)的技術差距,乃至實現(xiàn)超越。R1V 2.0 不僅是當前最好的開源多模態(tài)推理模型,也是我們邁向 AGI 路上的又一重要里程碑。昆侖萬維將繼續(xù)秉持“開源、開放、共創(chuàng)”的理念,持續(xù)推出領先的大模型與數(shù)據(jù)集,賦能開發(fā)者、推動行業(yè)協(xié)同創(chuàng)新,加速通用人工智能(AGI)的實現(xiàn)進程。